Doç. Dr. Özgür Baştürk

Ankara Üniversitesi, Astronomi ve Uzay Bilimleri Bölümü

obasturk at ankara.edu.tr

http://ozgur.astrotux.org

Bu derste neler öğreneceksiniz?¶

Monte Carlo Yöntemleri¶

Bayesian İstatistiğe Giriş¶

Monte Carlo Yöntemleri¶

Giriş¶

Şu ana kadar değişkeni tek bir olasılık dağılmından değer alan problemler üzerinde çalıştık. Ancak fen bilimlerinde karşılaşılan problemler genellikle birden fazla değişken içerebildiği için, çözümleri de birden fazla olasılık dağılımının kombinasyonunu gerektirir. Söz konusu problemlerde değişkenlerin alabileceği değerlerin belirli aralıkları için olasılıkları, bu dağılımların bu aralıklardaki integrasyonu (ya da toplamı) ile elde edilir.

Monte Carlo Yöntemleri, değişkenlerin olasılık dağılımlarından rastgele örneklemler üretip, bunların kombine olasılıklarını belirlemek için çoklu integrasyonlar yapabilmeye olanak sağlayan tekniklere verilen isimdir. Tekrarlanan rastgele örneklemlerle belirlenen değişken olasılıklaırnın kombinasyonu, nümerik integrasyonla elde edilir.

Örneklemin rastgeleliğine dayandıkları için bu yöntemler Fransa’nın kumarhaneleriyle meşhur şehri Monte Carlo’nun adıyla bilinirler.

Örnek: pi sayısının hesabı¶

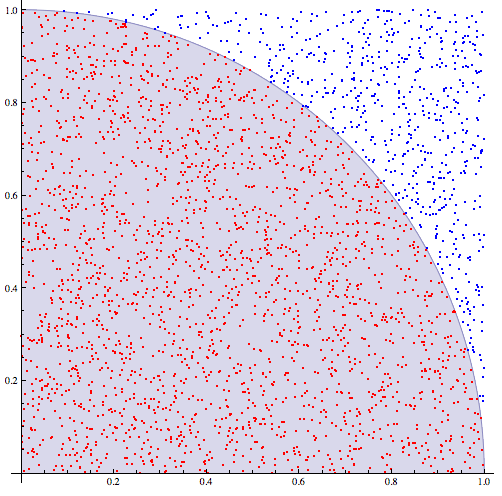

Diyelim ki $\pi$ sayısının değerini bir dairenin alanının ($A_{daire} = \pi r^2$) dörtte birinin, içine yerleştirdiğimiz bir karenin ($A_{kare} = r^2$) alanına oranını kullanarak hesaplamak istiyoruz ($A_{daire} / A_{kare} = \pi$).

Alan formülleri dahil olmak üzere hiçbir teorik yaklaşım barındırmayan tamamen empirik (deneysel) bir yol izleyelim ve bir çeyrek daire ile onun yarıçapını bir kenar kabul eden bir daire çizelim. Sonra karenin içerisine konumlarını tekdüze (ing. uniform) bir dağılımdan rastgele seçtiğimiz noktalar ($N_{kare}$) yerleştirelim. Çeyrek dairenin içindeki noktaları sayalım ($N_{daire}$) ve toplam nokta sayısına oranlayalım. Bu bize $\pi$ sayısını bir belirsizlik dahilinde verecektir.

Kareye yerleştirilen $N_{kare}$ tane nokta için çeyrek dairenin alanının ölçümü üzerindeki belirsizlik ($\sigma$), $p = A_{daire} / A_{kare}$ olasılıklı binom dağılımının standart sapması ile verilebilir. Çünkü çeyrek dairenin alanı, içine düşen (ya da düşmeyen) nokta ile belirlenir.

$$ \sigma = \sqrt{N_{kare}~p~(1-p)} = \sqrt{N_{daire} (1 - p)} $$Dolayısıyla, nokta sayısı $4$ kat artarsa, çeyrek dairenin alanı üzerindeki belirsizlik $\sqrt{4} = 2$ kat azalacaktır.

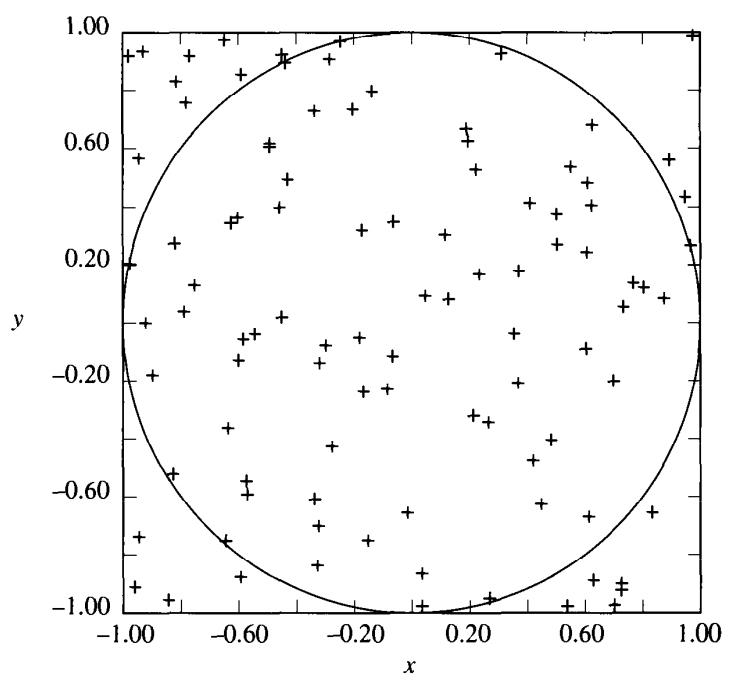

Diyelim ki 1 birimlik yarıçapa sahip bir daireyi 2 birim kenar uzunluklarına sahip bir karenin içine yerleştirmiş olalım. Bu biraz önce ele aldığımız problemle aynıdır. Çünkü çemberin dörtte biri 1 birimlik kenar uzunluklu karenin içinde kalır. Bu birim seçimleriyle dairenin alanını bulduğumuz vakit $\pi$ sayısını da bulmuş oluruz.

$$ \frac{A_{daire}}{A_{kare}} = \frac{\pi~1^2}{2^2} = \frac{\pi}{4} $$$-1$ ile $1$ arasında değer alan $x$ ve $y$ koordinatlarından $N = 100$ tane rastgele (x,y) çifti üretelim. Bu durumda rastgele belirlenen bir koordinatın daire içine düşme olasılığı $p = \pi / 2^2 = \pi / 4$ olur. Dolayısıyla 100 denemede çember içine isabet eden noktaların ortalama sayısı ($\mu$);

$$ \mu = N~p = 100~\frac{\pi}{4} = 78.5 $$olur. Ortalamanın standart sapması ise

$$ \sigma = \sqrt{N~p~(1-p)} = \sqrt{100~\frac{\pi}{4}~(1 - \frac{\pi}{4})} = 4.1 $$olur.

Dolayısıyla, nokta sayısı $4$ kat artarsa, çeyrek dairenin alanı üzerindeki belirsizlik $\sqrt{4} = 2$ kat azalır.

$$ \frac{A_{daire}}{A_{kare}} = \frac{N_{daire}}{N_{kare}} \Rightarrow A_{daire} = A_{kare}~\frac{N_{daire}}{N_{kare}} = 2^2~\frac{78.5 \pm 4.1}{100} = 3.14 \pm 0.16 $$Aşağıdaki şekilde $100$ rastgele çiftle yapılmış deneyin sonucu görülmektedir. Bu deneyde dairenin içine $73$ nokta isabet etmiştir. Dairenin içerisine düşecek nokta sayısında hiçbir öncül ("a priori") bilgimiz olmasaydı $p = 73 / 100$ alabilirdik. Bu durumda çemberin alanını ($\pi$) aşağıdaki şekilde buluruz.

$$ \sigma = \sqrt{100~0.73~(1-0.73)} = 4.44 $$$$ A_{daire} = A_{kare}~\frac{N_{daire}}{N_{kare}} = 2^2~\frac{73 \pm 4.4}{100} = 2.92 \pm 0.18 $$

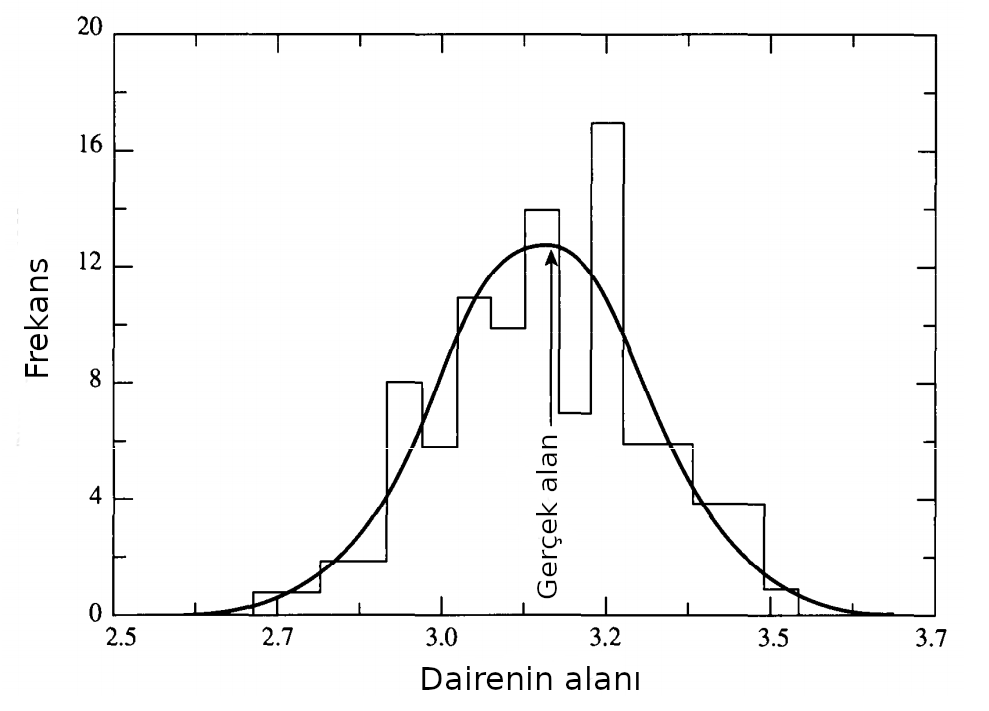

Aşağıda bu kez tekdüze bir dağılımdan $N = 100$ rastgele seçilen koordinat ikilileri üzerinden birbirinden bağımsız yapılan $100$ Monte Carlo deneyinden toplamda $10000$ rastgele belirlenmiş koordinatla oluşturulmuş bir histogram görülmektedir. $100$ Monte Carlo deneyinden elde edilen çember alanlarının ortalaması $A = 3.127$, standart sapması $\sigma = 0.156$ birim$^2$ olarak bulunmuştur. Sürekli eğri bu ortalama değer ve standart sapmaya sahip bir Gaussyen dağılımı göstermektedir.

Markov Zinciri¶

Her ne kadar $\pi$ sayısının hesabı için verilen örnek oldukça basitse de Monte Carlo yöntemlerinin dayandığı temel mantığı anlamak açısından açıklayıcıdır. Temel mantık bir olasılık dağılımından (burada tekdüze dağılım) rastgele örneklemler üretip, bu örneklem için olasılık hesabı yapmaktan ibarettir.

Markov özelliği (ing. Markov property) herhangi bir rastgele durumun "hafızasızlık" (ing. memorylessness) özelliği taşıması, yani kendisinden önceki durumlardan bağımsız olması demektir.

Markov zinciri (ing. Markov chain) ise, Markov özelliği taşıyan durumlar arasındaki olasılık temelli süreksiz geçişler sürecine verilen isimdir.

Örneğin, zar oyunları birer Markov zinciridir. Ancak kart oyunları, oynadıkça destedeki kartların sayıları ya da türleri değiştiği için hafızaya sahiptirler ve Markov özelliğine sahip değildirler. Bu sebep ile bir Markov zinciri oluşturmazlar.

Örnek: Günlük Hava Durumu Tahminleri¶

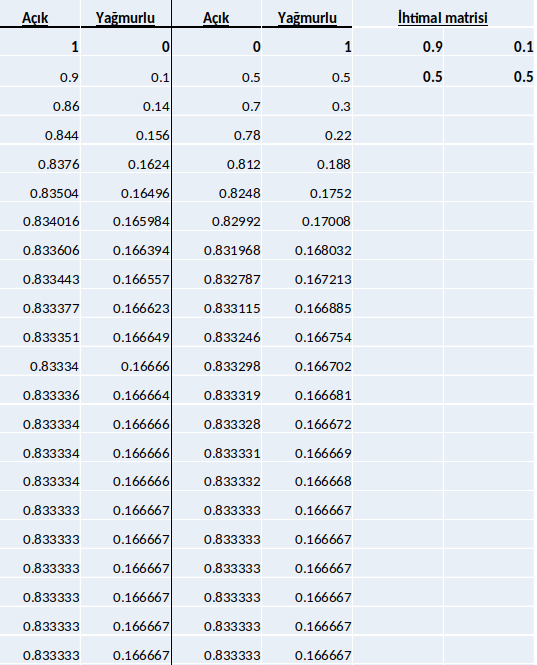

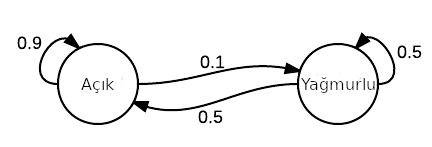

Diyelim ki bir günün hava durumunu tahmin edebilmek için aşağıdaki (belirli bir düzeyde makul) yöntemi takip ediyoruz:

- Hava açık ise bir sonraki gün %90 ihtimalle açık olacaktır.

- Hava yağmurlu ise bir sonraki gün %50 ihtimalle yağmurlu olacaktır.

Buna göre ileri bir tarihin hava durum için bir tahmin hesaplandığında başlangıçta hava nasıl olursa olsun bir süre sona havanın $0.8333$ ihtimalle açık, $0.1667$ ihtimalle yağmurlu olacağı sonucuna varılır (aşağıdaki tablo). Bu hesap başlangıç hava durumundan bağımsızdır. Aşağıdaki tablo her iki durum (1. gün açık (ilk 2 sütun) veya yağmurlu (üç ve dördüncü sütun)) için de ayrı ayrı düzenlenmiştir.

Belirli bir günden sonra ihtimal değeri değişmemeye başlar. Bu değere Markov Zinciri’nin denge dağılımı (ing. equilibrium distribution) adı verilir.

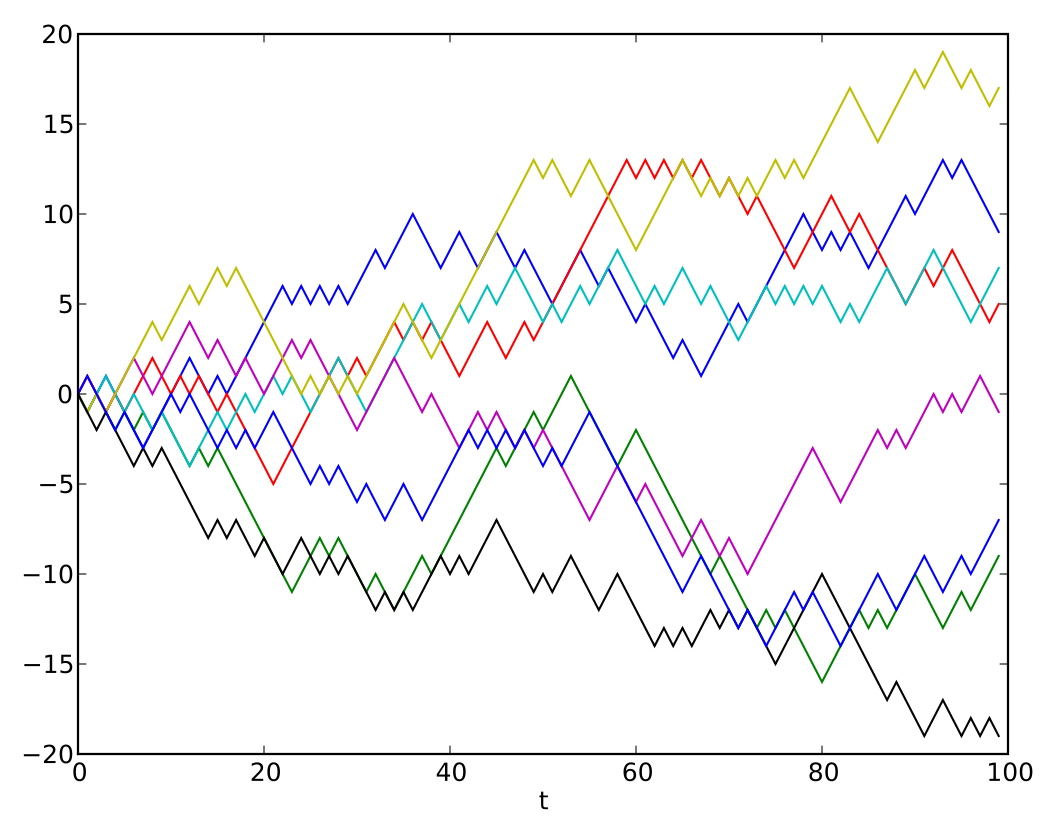

Rastgele Yürüyüş¶

Rastgele yürüyüş, bir matematiksel uzayda, rastgele adımlar atarak izlenilen yolu açıklayan rastgele bir süreçtir. Örnek olarak, bir akışkandaki parçacığın yolu, yemek arayan bir böceğin yolu, bir fotonun yılıdız içindeki yolculuğu rastgele yürüyüş yaklaşımı ile incelenebilir. Rastgele yürüyüş süreçleri Markov özelliğini taşıdığı sürece birer Markov zinciridir.

Monte Carlo Markov Zinciri MCMC¶

Bir olasılık dağılımı üzerinden örneklemler ile, Markov zincirinin denge dağılımına ulaşmayı hedefleyen algoritmalar grubuna verilen isimdir. Fizik, biyoloji, ekonomi, dilbilim gibi birçok farklı alanda kullanılmaktadır. Örneklenmek istenen soruna ilişkin boyut sayısının yüksek olması, diğer yöntemleri kullanışsız hale getirirken (bkz. ing. curse of dimensionality) MCMC yöntemleri çoğu zaman uygulanabilir tek yöntem olmaktadır. Genellikle rastgele yürüyüş mantığı ile çalışan algoritmalar kullanır. Bunlardan bazıları:

- Metropolis-Hastings

- Gibbs

- Slice

- Reversible-jump

Metropolis Hastings Algoritması¶

Bu algoritma, belirli bir olasılık dağılımından elde edilen rastgele örneklerin, doğrudan (ana) dağılımın kestirilmesinde ya da integral hesaplamasında kullanılmasına dayanmaktadır.

Ardarda üretilen rastgele değerler, bir olasılık karşılaştırmasına tabi tutularak seçilir. Bu şekilde Markov zincirinin denge dağılımına erişilene kadar yeni rastgele değerler üretilmeye devam edilir.

Tekrar sayısı ne kadar fazla olursa, denge dağılımını örnekleme kalitesi o oranda artar.

Algoritma aşağıdaki adımlar üzerine kuruludur:

1) Rastgele başlangıç parametre seti ($x_0$) oluşturulur. 2) Varsayılan bir olasılık dağılımından bir diğer parametre seti ($x_i$) seçilir. 3) İki setten hangisinin kabul edileceği aşağıdaki şekilde belirlenir: Eğer random(0,1) <= min(1, P(xi)/P(xi+1)) ise $x_i$ seti seçilir. Değilse; $x_{i+1}$ seti seçilir. 4) Hesaplama 2. adımdan istenilen sayıda tekrarlanır. 5) Hesap tekrarı (iterasyon) tamamlandıktan sonra seçilen parametrelerin histogramları oluşturulur. 6) Histogramlarda en çok tekrar eden değer aralıkları parametrelerin değer aralığı olarak kabul edilir.

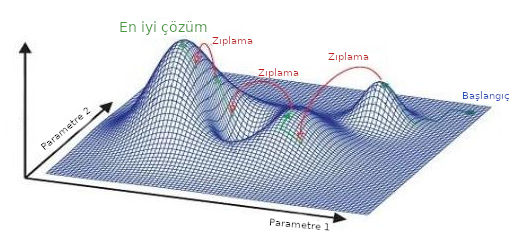

Rastgele üretilen daha olası parametre setinin, $0-1$ arasında tekdüze bir dağılımdan rastgele seçilen bir sayı ile karşılaştırılması, yerel minimuma hapsedilmeyi önleyip global minimumun bulunabilme ihtimalini arttırır; ancak bu ihtimal her zaman vardır. Yerel minimuma hapsolmamak için farklı ilk parametre setlerine doğrudan "zıplamak" gerekebilir.

Bu algoritmada, kaç defa parametre seti oluşturulması gerektiği bilinmemektedir.

Üretilen ilk değerlerin, istenilen dağılımdan çok uzak değerler alması olasıdır. Bu sebep ile ilk tekrarların önemli bir kısmı hesaba katılmadan ayıklanır; bu aralığa "ısınma dönemi" (ing. Burn-in) adı verilir. Isınma dönemine dahil olan tekrar sayısı da önceden bilinmemektedir.

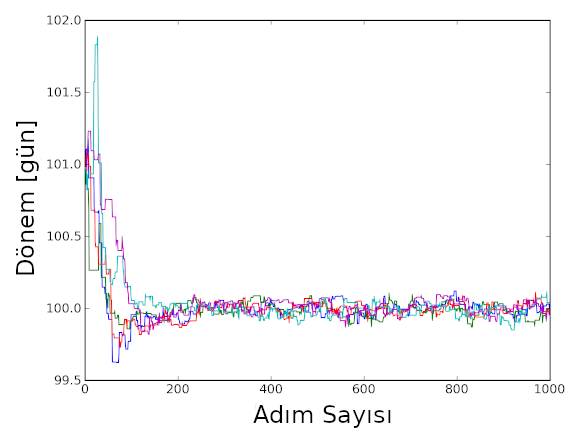

Aşağıda bir çift yıldızın dönemi sürekli olarak değiştirilerek bir O-C analizinde en küçük farkı verecek yörünge dönemi aranmaktadır. x-ekseni adım sayısını; y-ekseni gün cisinden yörünge dönemini göstermektedir. Renkli her bir eğri başka bir rastgele yürüyüşü (ing. random walk) göstermekte, birden fazla yürüyücüyle en iyi çözüm aranmaktadır.

Eğer üretilen parametre setleri birbirlerinden önemli miktarda farklı değerlere sahip olursa, setlerin karşılaştırılması sonucunda yeni setin reddedilme sıklığı artar. Bu durumda kullanılmayan setler üretilmiş olur.

Eğer parametre setleri birbirlerine çok yakın değerlere sahip olurlarsa, yeni setler büyük ihtimalle kabul edilmekle birlikte, istenilen dağılıma ulaşmak için aşırı set üretimi gerekecektir.

Yukarıdaki iki durumda da işlem süresi uzayacaktır. Buradaki en büyük sorun, yeni setlerin üretileceği dağılımların seçimi için genel bir kural bulunmamasıdır. Yani eldeki soruna özel çözümler üretmek gerekmektedir.

Rastgele üretilen ardışık parametre setleri birbirlerinden tam olarak bağımsız değildirler. Bu sebeple eğer birbirinden bağımsız setlerin incelenmesi ihtiyacı söz konusuysa, üretilen ve kabul edilen tüm setlerin sadece her $n$ tanesinden biri alınmalıdır. Bu durumda diğer setlerin kullanılmaması söz konusu olmaktadır.

Bayesian İstatistik Paradigması¶

Olasılık kavramına temel yaklaşımında fark bulunan iki önemli istatistik paradigması vardır: Bayesian yaklaşım ("Bayesci") ve Frekansçı (klasik) yaklaşım.

Frekansçı (klasik) yaklaşımda parametre değerleri için bir popülasyon varsayılır. Bu popülasyon uzun vadede, herhangi bir deney ya da olayın sonsuz kez gerçekleştirilmesi sonucu parametrelerin aldığı değerleri temsil eder. Gerçekte böyle bir popülasyon yoktur. Ancak örneğin bir yazı / tura atışında sonsuz kez bu deneyin yapılması sonucu atışların yarısının "Tura", diğer yarısının ise "Yazı" geleceğini varsayarak parametrenin her iki değerini $\%50$ olasılık atarız. Bir başka deyişle, klasik yaklaşımda yazı gelme olasılığı da tura gelme olasılığı da birbiriyle aynı koşullarda sonsuz kez gerçekleştirilmiş bir yazı-tura deneyinde yazı (ya da tura) gelme sıklıklarını değerlendirmektir. Bu durumda atılan her bir yazı-turayla değişen şey veridir, yazı ve tura gelme olasılıkları yani modelin parametreleri ise sabittir! Bu nedenle, frekansçı yaklaşım "objektif" bir yaklaşımdır. Zira deneylerin öncülü (ing. prior) olmadığı gibi, deneyin herhangi bir sonucuna yönelik bir "inanç" da söz konusu değildir. $n$ kez tekrarlanan bir deneyde bir $x$ olayının $n_x$ kez gözlenmesi durumunda olasılığı;

$$ P(x) = \frac{n_x}{n} $$ile verilir ve gerçek olasılığı ancak deneyin sonsuz kez tekrarlanmasıyla ulaşılabilir ($n \rightarrow \infty$).

1700'lerin ortalarında Thomas Bayes (1701-1761) tarafından geliştirilen Bayesian yaklaşıma göre bir $x$ olayının gerçekleşmesi olasılığı ona duyulan inancın bir ifadesidir. Bu istatistik paradigmasında bir $x$ olayının olasılığı, deney ya da gözlem yapılmadan önce $x$ olayının gözlenmesi olasılığına olan inancımız (ing. prior belief) ve eldeki veri (ing. evidence) dikkate alınarak hesaplanır. Yani veri sabittir, ancak modelin parametreleri değişkendir. Daha çok veri aldıkça olayın gerçekleşme olasılığına ilişkin "inancımızı", yani o olayın olasılığını güncelleriz.

Bayesian Olasılık Hesabı¶

Olasılıkların Bayesian istatistik parametresiyle nasıl hesaplanabileceğine geçmeden önce bazı olasılık kavramlarını hatırlamakta fayda var:

Marjinal Olasılık:¶

Herhangi bir olayı birlikte gerçekleştiği diğer tüm olaylardan ayırdığımızda (marjinalize ettiğimizde) tek başına gerçekleşme olasılığıdır.

Örnek: Diyelim ki $X$ bir bireyin bir hastalığının olması durumunu göstersin ve bu durum için iki olasıık var olsun: Hastalığını olması ($1$) ve olmaması ($0$).

$Y$ ise bir bireyin bu hastalığa ilişkin bir semptomu göstermesi ($1$) ya da göstermemesi ($0$) durumunu ifade etsin. Bu durumda aşağıdaki tabloda verilen dört olası durum oluşur.

| Y = 0 | Y = 1 | |

|---|---|---|

| X = 0 | 0.5 | 0.1 |

| X = 1 | 0.1 | 0.3 |

Bu durumda marjinal olasılık, "rastgele seçilen bir bireyin hastalığın bir semptomunu gösterme olasılığı nedir?" sorusunun cevabıdır.

Bu soruya cevap vermek üzere bütün $X$ değerleri için (hasta olma ya da olmama) $Y = 1$ (semptomu gösterme) olasılıklarını toplamalıyız.

$$ P(Y = y_0) = \sum_{x}^{} P(X = x, Y = y_0) $$$$ P(Y = 1) = P(X = 0, Y = 1) + P(X = 1, Y = 1) = 0.1 + 0.3 = 0.4 $$Bileşke Olasılık:¶

Herhangi bir olayın başka olay(lar)la birlikte gerçekleşme olasılığıdır.

Örnek: Rastgele seçilen bir bireyin hasta olma ve bu hastalığın semptomunu gösterme olasılığı nedir?

Bu durumda yukarıdaki olasılıklar tablosunda sadece her iki durumun birlikte gerçekleşme olasılığına bakmalıyız.

$$ P(X=1, Y=1) = 0.3 $$Koşullu Olasılık:¶

Herhangi bir olayın başka bir olayın gerçekleşmiş olması halinde (varsayımında) gerçeklşme olasılığıdır.

Örnek: Rastgele seçilen bir bireyin bir hastalığın semptomunu gösteriyor olduğu varsayımı (bilgisi) halinde hastalığa sahip olma olasılığı nedir?

Bu durumda bireyin sadece semptomu göstermesiyle, sadece hasta olmasıyla ya da hem semptomu gösterip, hem de hasta olmasıyla ilgilenemeyiz. İlgilendiğimiz eğer rastgele seçilen hasta semptomu gösteriyorsa (bu durumda bu olasılığı değerlendirmeliyiz) bu bireyin hasta olmasıdır; yani hasta hem semptomu göstermeli hem de hasta olmalıdır (bu olasılığı da değerlendirmeliyiz).

$$ P(X = x_0~|~Y = y_0) = \frac{P(X = x_0, Y = y_0)}{P(Y = y_0)} \rightarrow P(X = 1~|~Y = 1) = \frac{P(X = 1, Y = 1)}{P(Y = 1)} = \frac{0.3}{0.3 + 0.1} = 0.75 $$Not: Rastgele seçilen bireyin semptom gösteriyor olduğunun bilinip hasta olmama olasılığı da $0.25$’tir ($P(X=0~|~Y=1) = 0.25$, gösteriniz!) Bu iki olasılığın toplamı doğal olarak $0.75 + 0.25 = 1.00$ yapar!

Koşullu olasılık Bayes formülünü anlamak için kritik önemde olduğundan bir örnek daha verelim.

Örnek: Koşullu Olasılık Hesabı¶

Rastgele seçilen bir bireyin CoVid-19 hastası olma olasılığı $\%1$ olsun ($P(C) = 0.01$). Diyelim ki rastgele seçilen bir bireyin gerçekten virüse sahip olduğu bilindiğinde uygulanan PCR testinin de pozitif çıkma ihtimali $\%90$ ($P(+~|~C) = 0.90$), CoVid-19 hastası olmadığı bilindiğinde ise testin pozitif çıkma ihtimali $\%8$ ($P(+~|~\sim C = 0.08$) olsun. (Bu ikisinin toplamının 1.00 olmak zorunda olmadığına dikkat ediniz!)

Soru: Testi pozitif çıktığı bilinen bir hastanın gerçekten CoVid-19 hastası olma olasılığı ($P(C~|~+) = ?$) nedir?

Cevap vermemiz gereken soru $P(C~|~+) = P(C,+) / P(+)$ 'dır.

Ancak biz $P(C,+)$’yı (herhangi bir bireyin CoVid-19 hastası olma ve testinin pozitif çıkma olaslığını) da $P(+)$’yı (herhangi bir bireyin testinin pozitif çıkma olasılığını) da bilmiyoruz ama bulabiliriz!

$$ P(+~|~C) = \frac{P(+,C) }{P(C)} \rightarrow P(+,C) = P(C) \times P(+~|~C) $$$$ P(+~|~C) = 0.01 \times 0.90 = 0.009 $$Burada basit bir eşitliği kullandık bir bireyin hem CoVid-19, hem de PCR testinin pozitif olması olasılığı ($P(+,C)$) ile hem testinin pozitif, hem de hasta olma olasılığı ($P(C,+)$) aynı şeydir!

$$ P(+) = P(C,+) + P(\sim C,+) $$Burada $P(C,+)$'yı biliyoruz ama $P(\sim C,+)$’yı bilmiyoruz ama onu da bulabiliriz!

$$ P(+~|~\sim C) = \frac{P(+,\sim C) }{P(\sim C)} \rightarrow P(+,\sim C) = P(\sim C) \times P(+~|~\sim C) $$$$ P(+~|~\sim C) = (1 - P(C)) \times P(+~|~\sim C) = (1 - 0.01) \times 0.08 = 0.0792 $$Bu durumda,

$$ P(+) = P(C,+) + P(\sim C,+) = 0.009 + 0.0792 = 0.0882 $$ve

$$ P(C~|~+) = \frac{P(C,+)}{P(+)} = \frac{0.009}{0.0882} = 0.1020 $$Yani PCR testi pozitif çıktığı bilinen hastaların yalnızca $%10.20$’si gerçekten CoVid-19 hastasıdır! Testte pek çok yanlış pozitif (ing. false positive, Tip-II hatası) sonuç çıkmaktadır! CoVid-19 hastalığının testinde kullanılan PCR testlerinin başarımının $\sim \%70$ civarında olduğu dahi iddia edilmektedir.

Bayes Formülü¶

Bayesian istatistiğin temeli aşağıdaki basit formüle dayanır:

$$ P(\theta~|~veri) = \frac{P(veri~|~\theta) \times P(\theta)}{P(veri)} $$Burada;

$P(veri~|~\theta)$, Olabilirlik fonksiyonu (ing. Likelihood Function) : $\theta$ model olarak seçildiğinde söz konusu veri setini elde etme olasılığı,

$P(\theta)$, Öncül (ing. Prior): Herhangi bir ön bilgi (veri) olmaksızın $\theta$ gibi bir modelin (ya da teorinin) doğru olma olasılığı,

$P(veri)$, Veri (Kanıt, ing. Evidence): Tüm olası $\theta$ model seçimleri için söz konusu veri setini elde etme olasılığı (hesaplanmasının zor olacağı açıktır),

$P(\theta | veri)$, Ardıl (ing. Posterior): Eldeki veriye dayalı olarak $\theta$ modelinin geçerli olma olasılığı olarak tanımlanabilir. Aslında bu parametreler doğrudan olasılıklara karşılık gelmeyebilir, ancak başlangıç için bunları olasılık olarak düşünebilirsiniz.

Bayesian istatistik paradigmasının temel amacı $\theta$’nın bütün değerleri için birer olasılık değeri, bir başka deyişle, tüm $\theta$ modellerinin gerçekleşme olasılıklarını ayrı ayrı hesaplamaktır. Bu nedenle ardıl (posterior) bir olasılık dağılımıdır.

Bayes Formülünün Türetilmesi¶

Her ne kadar Bayesian istatistik frekansçı istatistikten farklı bir paradigma olsa da Bayes formülü klasik olasılık yaklaşımıyla türetilebilir.

Bir $A$ olayının $B$ olayına bağlı olarak gerçekleşme olasılığı olan koşullu olasılığın $B$ olayının gerçekleşmesi durumunda $A$ olayının gerçekleşmesinin olasılığı olduğunun görmüş ve aşağıdaki şekilde tanımlamıştık:

$$ P(A~|~B) = \frac{P(A,B)}{P(B)} $$Bu durumda,

$$ P(A,B) = P(A~|~B) \times P(B) $$Aynı şekilde,

$$ P(B~|~A) = \frac{P(B,A)}{P(A)} \rightarrow P(B,A) = P(B~|~A) \times P(A)$$Diğer taraftan bileşke olasılıklar birbirine eşit ($P(A,B) = P(B,A)$) olacağından ;

$$ P(A,B) = P(B,A) \rightarrow P(A~|~B) \times P(B) = P(B~|~A) \times P(A) $$$$ P(A~|~B) = \frac{P(B~|~A) \times P(A)}{P(B)} $$elde edilir ki, bu Bayes formülüdür.

Kavramsal Örnek: Hileli Madeni Parayla Yazı / Tura Atışı¶

Bayesian istatistik paradigmasıyla düşünme, yani deneyler ya da gözlemlerle elde edilen veriye ve arka plan bilgimize dayalı olarak bir olayın olası tüm sonuçlarının olasılıklarını hesaplamaya yönelik iyi bir örnek yazı / tura atış problemidir.

Bir kumarhanede bir seri yazı / tura atışı problemine tanıklık ettiğimizi düşünelim. Öğrenmeye çalıştığımız şey yazı / tura atışını yapan kişinin bir şekilde atışın sonuçlarını belirleyip belirlemediği, eğer belirliyorsa bunu hangi başarımda yaptığı olsun.

Problemi frekansçı (klasik) istatistik yaklaşımı ile ele alırsak madeni paranın hangi miktarda hileli olduğuna ilişkin bir sıfır hipotezimiz ($H_0$) olur (null hypothesis). Elimizdeki veriye (bir seri yazı / tura atışının sonucuna) ve yazı / tura atışları için olasılık dağılımı belirleyen bir dağılıma (örn. Bernoulli dağılımı) bakarak, belirlediğimiz anlamlılık düzeyinde (örn. 0.05) bu hipotezi reddedip reddedemeyeceğimizle ilgileniriz. Zarın olası tüm hilelilik durumlarının (hep yazı gelir, hep tura gelir, 3/4 oranında tura gelir vs.) olasılıklarını belirlemekle ilgilenmeyiz.

Şimdi aynı probleme Bayesian istatistik yaklaşımıyla yaklaşalım ve bu yolla Bayesian istatistiğin temellerini anlamaya çalışalım.

Problem: Bir kumarhanede yapılan 4096 seri yazı-tura atışının çoğunun (kaç tanesinin?) yazı gelmesiyle yapılan yazı / tura atışlarının hileli olmasından şüpheleniyoruz. Taraflı olabileceğinden (ing. bias-weighted) kuşkulandığımız bu atışlar konusundaki kuşkularımızı gidermek üzere, tüm yazı atışlarının $T = 0$ ve tüm tura atışlarının $T = 1$ ile temsil edildiği bir skala oluşturuyoruz. $T = 0.5$ bu durumda adil bir atışı temsil etmiş oluyor. Probleme Bayes teoremi ile yaklaşarak elimizdeki veri (4096 yazı / tura atışının sonucu), hiç veri görmeden her bir hileli durumun olasılığına dair inancımızı gösteren öncül (ing. prior) ve arkaplan (ing. background) bilgimiz (bir atışının sonucunun diğerini belirlemediği: $I$) ışığında atışların adil olup olmadığını belirleyen $T$ fonksiyonu için seçtiğimiz herhangi bir değerin ne kadar olası olduğudur (ardıl: posterior): $P(T | veri, I)$.

Öncül Fonksiyon (Prior): Elimizde hiçbir veri olmaksızın $T$’nin her bir değeri için sadece arkaplan bilgimize dayanarak atadığımız olasılık değeri bizim $T$’nin her bir değerinin olasılığına dair inancımız ya da önyargımızdır. Başlangıç olarak tüm hileli durumların eşit olasılıkta olduğunu varsayalım. Sonuçta bir kumarhanede neyin nasıl olacağını bilemeyiz. O nedenle $T$’nin her bir değerine aynı olasılığı veren tekdüze (ing. uniform) bir olasılık dağılım fonksiyonu kullanalım. Bu fonksiyon aşağıdaki şekilde ifade edilebilir.

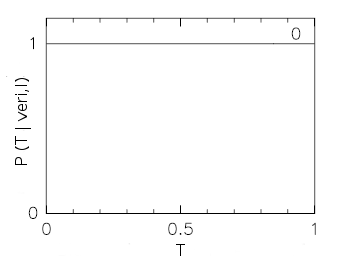

$$ P(T | I) = 1, 0 \leq T \leq 1 $$, $$ P(T | I) = 0, T < 0 , T > 1 $$

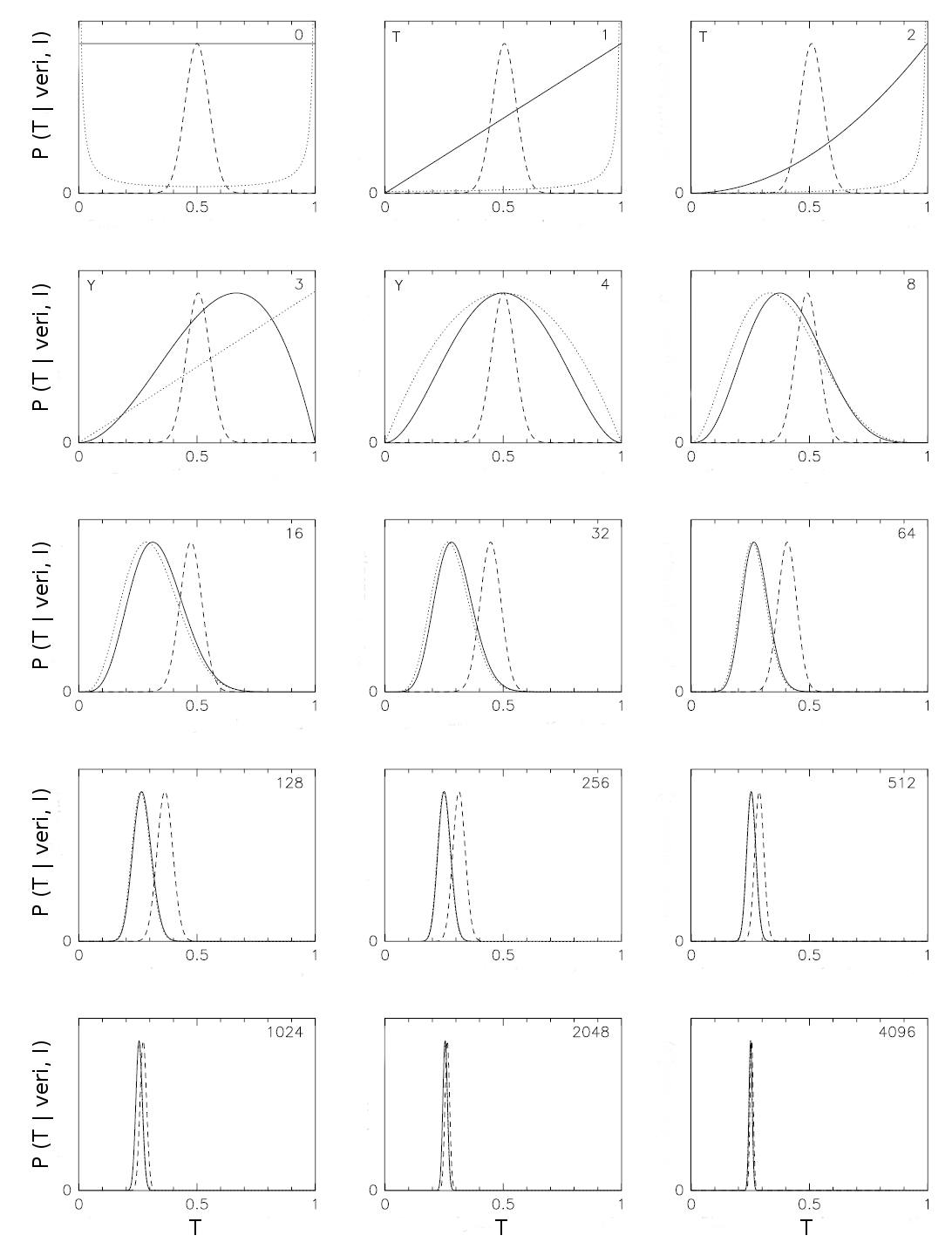

Yukarıda belirli bir sayıda deney yapılmadan önce paranın hangi olasılıkla tura (T) geleceği konusundaki inancımızı gösteren bir tekdüze dağılım görülmektedir (ing. prior distribution). $0$ tüm atışların yazı, $1$ tüm atışların tura gelme olasılığını göstermektedir. $n$ deney sonucunda $0$ ile $n$ arasında tura gelme olasılığı eşittir. Bu tür, herhangi bir teoriye ya da öngörüye dayanmayan öncüllere bilgi vermeyen (ing. uninformative) öncüller adı verilir. Sağ üst köşedeki 0, henüz atış yapmadığımızı göstermektedir.

Olabilirlik Fonksiyonu (Likelihood Function): Verilen bir hileli durum için (T’nin herhangi bir değeri için) elimizdeki veri setini (4096 yazı / tura atışının sonuçlarını) oluşturabilme olasılığımızı belirleyen fonksiyon olabilirlik fonksiyonudur. Arkaplan bilgimiz ışığında bunu hesaplayabiliriz. Arkaplan bilgimiz (I) bir atışın sonucunun bir sonrakini belirlemediğidir. Tıpkı klasik istatistikte olduğu gibi her bir hileli durum için elimizdeki veri setini üretebileceğimiz bir dağılım öngörüyoruz. Yazı / tura atışı gibi iki seçenekli durumlarda olasılıkların dağılımını Bernoulli dağılımı ile belirlediğimizi görmüştük ($P(x) = p^m (q)^{n-m}, q = 1 – p)$). Problemimizi kolaylıkla buna adapte edebiliriz. $p$ önermesini yazı / tura atışına atadığımız hilelilik durumu $T$, atışların tura gelmeye ayarlanma oranını gösterdiği için; $1-T$ de diğer seçenek yani yazı gelmeye ayarlanma oranını (yani $q$) göstermektedir ve bu ikisinin toplamı 1’dir. Atış ne şekilde hileli olursa olsun para ya yazı ya da tura gelir, üçüncü bir seçenek yoktur. Paranın $R$ denemede tura geldiğini ve $N$ kez atıldığını varsayarak $N-R$ denemede de yazı geldiği sonucu çıkar. Bu durumda olabilirlik fonksiyonu

$$ P(veri~|~T, I) = T^R~(1 – T)^{N-R} $$olarak belirlenmiş olur.

Kanıt (Evidence): Her bir $T$ durumu için elimizdeki veri setini (4096 yazı / tura atışının sonuçlarını) üretebilme ihtimalidir. Gördüğümüz gibi kanıt olabilirlik fonksiyonuna çok benzemekte, ondan tüm durumlar için olasılıkların toplamını belirlemesi bağlamında ayrılmaktadır. Yani olabilirlik fonksiyonu herhangi bir hileli durum ($T$’nin herhangi bir değeri) için bu veri setinin türetilme ihtimalini belirlerken, kanıt (evidence) tüm hileli durumlar için bu veri setinin türetilme olasılıklarının toplamıdır. Yani aslında T’nin herhangi bir değeri için olabilirlik fonksiyonunu da içeren ve tüm olasılıkları kapsayan bir normalizasyon terimidir. Sonuç olarak belilremek istediğimiz elimizdeki veriyle her bir $T$ durumunun (tek tek) gerçekleşme olasılğını gösteren ardıl olasılık dağılımıdır (ing. posterior probability distribution). Bu nedenle seçilmiş bir $T$ durumu için öncülümüzün (prior) ne öngordüğü ile olabilirlik fonksiyonunun bu $T$ durumu için elimizdeki veriyi üretme konusunda belirlediği olasılığın çarpımını tüm olası $T$ değerleri için bu veriyi üretme olasılığının toplamını ifade eden kanıta bölerek, söz konusu $T$ durumunun elimizdeki veri ile üretlimiş olma olasılığını (ardıl olasılık) bulmuş oluruz. Bunu tüm $T$ durumları için yapar ve toplarsak, toplamda 1 elde etmeliyiz! Görüldüğü gibi her bir ardıl olasılığın hesabı için hep aynı kanıtı (evidence) kullanıyoruz. O nedenle her bir $T$ durumunun doğrudan olasılığı yerine bunların birbirlerine göre ne kadar olası olduklarını karşılaştırmak istersek kanıtı hesaplamaya ihtiyacımız olmaz. Bayes teoremini bir eşitlik olarak değil bir bağıntı olarak yazmamız yeter:

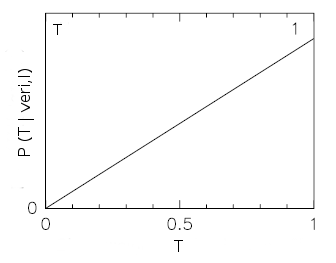

$$ P(T~|~veri, I)~\alpha~P(veri~|~T, I) \times P(T~|~I) $$İlk yazı / tura atışı: Örnek olarak ilk yazı / tura atışının ardıl (posterior) dağılımını hesaplayalım ve ilk atışın tura geldiğini varsayalım. Bu durumda, $P(veri | T, I) = T^R~(1 – T)^{N-R}$ şeklinde verilen olabilirlik fonksiyonunda $R = 1$ ve $N = 1$’dir. Olabilirlik fonksiyonu bu durumda,

$$ P(veri~|~T, I) = T^1~(1 – T)^{1-1} = T $$olarak belirlenmiş olur. Öncülümüz T’nin her değeri için eşit ve 1 idi.

$$ P(T~|~I) = 1 $$Ardıl olasılık dağılımı (posterior probability function) bu durumda aşağıdaki gibi bulunur.

$$ P(T~|~veri, I)~\alpha~P(veri~|~T, I) \times P(T~|~I) = T \times 1 = T $$

Şeklilde y-ekseni olasılık olarak belirtilmiş olmasına karşılık herhangi bir ölçek verilmemiştir. Bunun nedeni eksenin gerçekte bir Olasılık Yoğunluk Fonksiyonu (ing. Probability Density Function, PDF) biriminde olması ve olasılıkların eğrinin altında kalan alanlarla belirlenmesi ve kanıt hesaplanmadığı için bunların göreli olasılıklar olmasıdır. Eğer her bir $T$ durumu için veriyi elde etme olasılıkları (kanıt) hesaplanır ve hesaba dahil edilirse eğrinin altında kalan toplam alan 1’e eşit çıkar. Sol üst köşede en son yapılan atış ($T$: tura), sağ üst köşede ise toplam deney sayısı (yazı / tura atışı sayısı) verilmektedir. Görüldüğü gibi atışların tümünün yazıya ayarlanmış olma ihtimali kalmamıştır ($P (T = 0 | veri, I) = 0$). En büyük olasılık ise tüm atışların turaya ayarlanmış olması durumuna verilmiştir, zira şu ana kadar yapılmış olan tek atışın sonucu turadır.

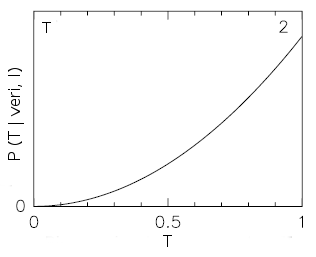

İkinci yazı / tura atışı: Şimdi ikinci yazı / tura atışın sonrası ardıl (posterior) dağılımını hesaplayalım ve yine tura geldiğini varsayalım. Bu durumda $R = 2$ ve $N = 2$’dir. Olabilrlik fonksiyonu,

$$ P(veri~|~T, I) = T^2 (1 – T)^{2-2} = T^2 $$olarak belirlenmiş olur. Öncülümüz $T$’nın her değeri için eşit ve 1 idi.

$$ P(T~|~I) = 1 $$Ardıl olasılık dağılımı (posterior probability function) bu durumda aşağıdaki gibi bulunur.

$$ P(T~|~veri, I)~\alpha~P(veri~|~T, I) \times P(T~|~I) = T^2 \times 1 = T^2 $$

Görüldüğü gibi $T > 0.5$ durumları (atışların çoğunun tura gelmeye ayarlanmış olma durumu) giderek daha olası hale gellirken $T < 0.5$ durumlarının olasılığı giderek azalmaktadır. Zira ilk 2 atışın 2’si de tura gelmiştir. Yine en büyük olasılık tüm atışların turaya ayarlanmış olması durumundadır ($T = 1$).

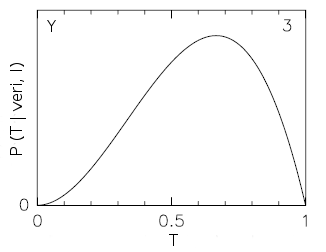

Üçüncü yazı / tura atışı: Şimdi üçüncü yazı / tura atışı sonrası ardıl (posterior) dağılımını hesaplayalım ve bu kez (sonunda!) yazı geldiğini varsayalım. Bu durumda $R = 2$ ve N = 3’tür. Olabilrlik fonksiyonu;

$$ P(veri~|~T, I) = T^2~ (1 – T)^{3-2} = T^2~(1 - T) $$olarak belirlenmiş olur. Öncülümüz T’nin her değeri için eşit ve 1 idi.

$$ P(T~|~I) = 1 $$Ardıl olasılık dağılımı bu durumda aşağıdaki gibi bulunur.

$$ P(T~|~veri, I)~\alpha~P(veri~|~T, I) \times P(T | I) = T^2~(1 - T) \times 1 = T^2~(1 - T) $$

Artık tüm atışların tura gelmeye ayarlanmadığını da biliyoruz. Zira son atışımız yazı (Y) gelmiştir: $P(T = 1~|~veri , I) = 0$.

Ancak hala atışların çoğunun tura gelmeye ayarlandığı düşüncesi hakimdir ve ardıl dağılımda açıkça görülmektedir. $P(T > 0.5~|~veri, I) > P(T < 0.5~|~veri, I)$.

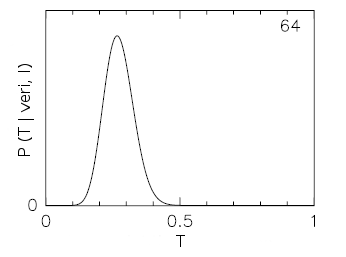

64. yazı / tura atışı sonrası: Deneyi yapmayı sürdüyor, her durumda ardıl dağılımı hesaplıyor ve grafiğe geçiriyoruz. Burada y-ekesninde olasılık yoğunluğu dağılımının göreli bir ifadesinin olduğunu hatırlatalım. Aksi durumda hesaba kanıtı da dahil etmemiz gerekirdi. Diyelim ki 64. atış sonunda aşağıdaki gibi bir ardıl olasılık dağılım fonksiyonu elde etmiş olalım.

Gördüklerimiz giderek bizi yazı / tura atışlarının adil olmadığına "ikna" ediyor. Başlangıçta tüm olasılıklara eşit şans tanırken 64 atış sonunda tüm atışların neredeyse 3/4’ünün yazı gelmeye ayarlanmış olduğu kanısına varıyoruz. Hala diğer durumlar da olası ama olasılıkları daha az!

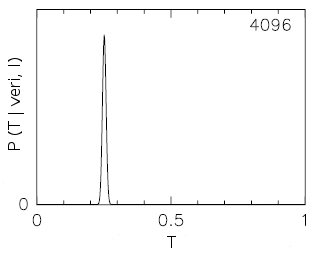

4096. yazı / tura atışı sonrası: Tüm atışlar tamamlandığında artık atışların hileli olduğundan neredeyse eminiz ve bu hilelilik oranı da $T = 0.25$ (ki bu dağılımın standart sapması üzerinden belirsizliğini de belirleyebilirdik). Yani atış dört atışın birinde Tura, üçünde Yazı gelmeye ayarlanmış.

Farklı Öncül Fonksiyonların Seçimi¶

Acaba tekdüze (ing. uniform, flat) bir öncül (prior) yerine farklı öncüller kullansak sonuç değişir miydi? Örneğin parayı adil varsaysak ve maksimum olasılığı $T = 0.5$ olan ve $T = 0.35$ ile $T = 0.65$ arasında olasılığın daha fazla olduğu bir dağılımla yola çıksak (aşağıdaki şekilde --- kesikli eğri), ya da parayı inanılmaz yanlı olarak hayal ettiğimiz ve maksimum ağırlığı paranın tamamen yazı ya da tamamen tura gelme olasılıklarına doğru dağıttığımız bir olasılık dağılımı (aşağıdaki şekilde .... noktalı eğri) ile yola çıksak ne olur? Karşılaştırma için her durumda elde edilen ardıl olasılık dağılım fonksiyonları (posterior pdf) aşağıdaki şekilde verilmektedir. Deney sayısı arttıkça aynı sonuçları elde etmemiz durumunda (yani veri setimizin değişmemesi durumunda) dağılımın aynı ardıla (posterior pdf) doğru evrildiği açıktır.

Şekle bakılarak her dağılımın aynı maksimum olasılık değerlerini verdiği düşünülmemelidir. Daha iyi bir karşılaştırma için ardıl (posterior pdf) değerleri tekdüze dağılımla elde edilene ölçeklenmiş durumdadır. Ancak sonuç olarak öncül bilgimiz ve yaklaşımımız ne olursa olsun veri arttıkça olabilirlik fonksiyonunun öncülü domine etmesi nedeniyle olayın doğasının gerektirdiği olasılık dağılımına yakınsanmaktadır. Başlangıçtaki öncüle bağımlılık giderek azalmakta başlangıç inancımız ne olursa olsun deneysel kanıtın artmasıyla aynı sonuçlara ulaşılmaktadır.

Şekilde görülen bir başka sonuç ancak bin küsür atış sonrası paranın doğasına yönelik olan inancımızın güçlendiğidir. Diğer bir husus da paranın tüm hileli durumlara eşit olasılıkla sahip olduğu durum (sürekli eğri) ile paranın neredeyse tamamen hileli varsayıldığı (noktalı eğri) durum hızla birbirine yaklaşır ve bir $T$ değerini yakınsarken, hemen hemen adil olduğunun varsayıldığı öncülle yola çıkıldığında (kesikli eğri) yakınsamanın ancak 2000 deneyden sonra gerçekleşmesidir. Birinci gözlemimizin nedeni paranını hilelilik derecesinin çok yüksek olmamasıdır, yoksa hemen farkedilirdi. İkinci gözlememiz ise kesikli eğriyle gösterilen öncülün tekdüze ve hileliği yüksek para yaklaşımlarına göre daha az belirsizlik içermesiyle açıklanabliir. Zira tekdüze öncül zaten tamamıyla düzdür. Hileliği yüksek zar yaklaşımı (noktalı eğri) da $T$'nin çok fazla değeri için neredeyse düzdür. Kesikli eğri ise Gaussyen'e benzeyen bu nedenle de adil bir zar yaklaşımına daha yakın bir yaklaşımdır. O nedenle de zarın hileli olduğuna çok daha zor "ikna" olmaktadır.

Öncüller zarın hileli olduğuna ilişkin başlangıç varsayımları (önyargıları) farklı 3 insan gibidir. Başlangıçta bütün veriyi kendi önyargılarının gözünden değerlendirmektedirler. Ancak bu 3 insan da ne kadar önyargılı başlasalar da "makul" insanlardır ve veriyi gördükçe yaklaşımlarını değiştirmektedirler ve ikna olmaya açıktırlar. En zor ikna olan doğal olarak başlangıçta zarların hileli olmadığı konusunda en önyargılı olan olacaktır. Dolayısı ile öncül bütünüyle önemsiz değildir. Veri sayısına ve bilgi düzeyimize göre yanlılıklarımız çıkarımlarımızda önemli rol oynayabilir. Doğal olan da budur ve gerçekten biz bu deneyimi yaşarız. Gerçekten en uzakta yanlılığa sahip olanlar inatçılıkları oranında gerçeğe en az uyananlardır. Ama gerçek orada durur ve daha çok veri gördükleri vakit o gerçeğe eninde sonunda "uyanırlar".

Adım Adım Ya Da Tek Adımda Veri Analizi¶

Acaba $N$ tane örnekten oluşan $D_k = (D_1, D_2, D_3, .., D_N)$ veri setini (N atıştan oluşan tek bir yazı / tura deneyi) tek bir kere de alıp analiz etmekle $(P(T | D_k, I))$, biraz önce yazı / tura deneyinde yaptığımız gibi veri geldikçe analiz etmek ($P(T | D_1, I)$, $P(T | D_2, I)$, ... ) arasında bir fark var mıdır? Öncelikle durumu sadece 2 veri açısından ($D_1$ ve $D_2$) değerlendirelim.

İlk olarak bu iki veriyi aynı anda analiz ettiğimizi varsayalım. Bu durumda ardıl olasılık yoğunluk fonksiyonu:

$$ P(T | D_2, D_1~|~I)~\alpha~P(D_2, D_1~|~T,I) \times P(T~|~I) $$Bu kez diyelim ki öncelikle $D_1$'i gözledik ve $D_1$ ile öncülümüze dayalı olarak $D_2$ verisi de alındıktan sonra ardıl olasılık yoğunluk fonksiyonunu hesaplıyoruz. Bu kez,

$$ P(T | D_2, D_1~|~I)~\alpha~P(D_2~|~T,D_1,I) \times P(T~|~D_1,I) $$Bu ifadenin en sağındaki öncülün $D_1$ ile yapılan analizin sonucunda elde edilen ardıl olasılık yoğunluk fonksiyonu (posterior) olduğu kolayca görülebilir. Bu ifadedeki olabilirlik fonksiyonu ise klasik kullandıklarımızdan bir miktar farklı olmakla birlikte verilerin birbirinden bağımsız oldukları, yani bir veriyle ulaşacağımız sonuç ikincisiyle ulaşacağımızdan (ya da tersi) bağımsızdır. Örneğin beşinci kez para atışı soncunda yapacağımız analiz dördüncünün sonucundan bağımsız olmalıdır. Bu durum matematiksel olarak şu şekilde ifade edilebilir:

$$ P(D_2~|~T,D_1,I) = P(D_2~|~T,I) $$Bu ifade yukarıdaki ikinci ifadede yerine konduğunda 1. ifade elde edilir ki bu adım adım ilerleyerek analizle, tek bir seferde tüm verinin analizi arasında bir fark olmadığını ortaya koyar.

İteratif Bir Yöntemle Daha İyi Sonuç Elde Edilebilir Mi?¶

Burada iteratif yöntemden kasıt aynı verinin analizinde bir adımda elde edilen ardılın (posterior) bir sonraki adımda öncül (prior) olarak kullanılmak suretiyle izlenen bir yöntemdir. Böyle bir yöntem yanlış ve yanıltıcı sonuçlar verir! Bu tür bir "boot-strapping" yöntemi bir ardıl olasılık yoğunluk fonksiyonunu tekrar kendisine bağlar. Veri değişmediği için bu iki ardıl fonksiyon birbirine ancak eşit olabilir, bir olabilirlik fonksiyonu ile bağlanamaz. Eğer ısrar edilirse iterasyonun birinci adımında ulaşılan ardılın öngördüğü en muhtemel değer etrafında giderek keskinleşen dağılım fonksiyonları elde edilir ve veri analizcisi yaptığının doğru olduğuna yanlış bir şekilde giderek daha fazla inanır. Bir analizi iyileştirmenin tek yolu daha fazla veri almak ya da veri az ise gerçekçi öncül ve olabilirlik fonksiyonları kullanmaktır.

Parametreler İçin En İyi Tahmini Değerler, Hataları ve Güven Aralıkları¶

Ardıl olasılık fonksiyonunun (ing. posterior pdf) analiz sonuçlarını nasıl ortaya koyduğunu gördük: parametrenin her olası değer aralığı için bir olasılık değeri belirleyerek! Ancak bazen bir parametre için en olası değere ve bu değer için de bir güven düzeyine (ing. confidence level) ihtiyacımız olur. En iyi tahmin açık ki ardıl olasılık dağılımının aldığı maksimum değere denk gelen parametre değeridir. Matematiksel olarak bu değeri ($X_0$) ardılın ($P(X~|~veri, I)$) türevini alıp $0$'a eşitleyerek bulabiliriz.

$$ \frac{dP}{dX}|_{x_0} = 0 $$Yine matematiksel olarak bu noktanın maksimum olduğunu güvence altına almak için ikinci türevin $0$'dan küçük olup olmadığı da kontrol edilmelidir. Süreksiz durumda iş daha kolaydır zira y-ekseni doğrudan olasılıktır (posterior probability mass function). En olası değer de o maksimum olasılığın olduğu $X$ değeri olur.

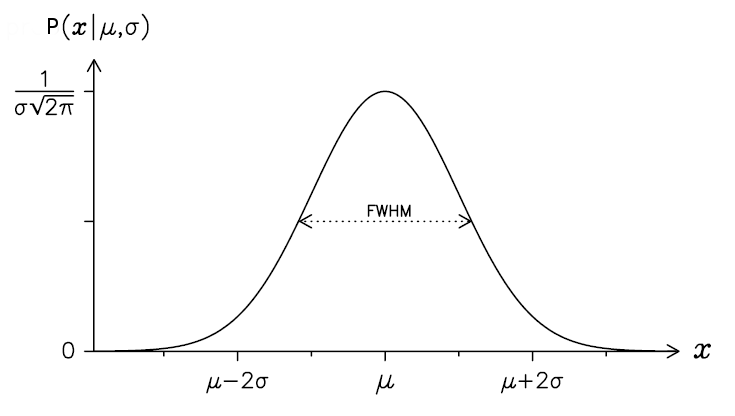

Bu değerin güven düzeyi için ise ardılın $x_0$ civarında nasıl dağıldığına bakılır. Herhangi bir fonksiyonun bir nokta etrafında nasıl dağıldığına bakmanın iyi bir yolu, fonksiyonun o nokta civarında Taylor açılımını elde etmektir. Aslında bu o nokta civarında fonksiyona düşük dereceden bir polinom fiti yapmakla özdeştir. Genellikle bu durumda pdf'in kendisinin yerine daha yavaş değiştiği için onun logaritması ile ilgilenilir ($L = ln(P(X~|~veri,I)$). Bu durumda ardılın $x_0$ civarındaki Taylor açılımı:

$$ L = L(x_0) + \frac{1}{2} \frac{d^2L}{dX^2}|_{x_0} (X - x_0)^2 + ... $$Bu tanım dahilinde en iyi tahmin $dL / dX = 0$'ın karşılık geldiği $x_0$ değeri olur. Maksimum civarında bir seri açılımı olduğu için lineer terim bu seride bulunmaz. Birinci terim ($L(x_0)$) da bir sabit olup ardılın şekliyle ilişkili değildir. Dolayısı ile ardılın şeklini (en olası değer etrafındaki saçılmasını) kuadratik terim temsil eder. Diğer tüm üst dereceden terimleri çok küçük olacakları gerekçesiyle ihmal edecek olursak

$$ P(X~|~veri,I) = A~exp[\frac{d^2L}{dX^2}|_{x_0} (X - x_0)^2] $$Tekrar ardıla geçmek için $L$'nin eksponansiyelini almalıyız. Bu durumda $x_0$ civarında $pdf$ yukarıdaki fonksiyonla ifade edilmiş olur. Aslında bu şekilde $x_0$ civarında seriyi Taylor serisinie açmakla $x_0$ civarında ardılı bir Gaussyen fonksiyonla ifade etmiş oluruz. Burada $A$ bir normalizasyon sabitidir. Ardıl böylece bir Gaussyen, bir başka deyişle bir normal dağılım olmuş olur.

Bu dağılımın standart sapması $L$'nin $X = x_0$'daki ikinci türevinin karekökü ile ters orantılıdır.

$$ \sigma = (-\frac{d^2L}{dX^2}|_{x_0})^{-1/2} $$$X$ parametresi için en iyi tahmin (en olası değer; best estimate) ise klasik şekilde verilir $X = x_0 \pm \sigma$. Doğal olarak normal dağılımın gereği $X$'in gerçek değerinin $x_0 \pm 1~\sigma$ arasında olma ihtimali $\%67$'dir. Örneklemde yeterince veri olması durumunda medyan da en olası değer için kullanılabilir.

$$ P(x_0 - \sigma \leq X \leq x_0 + \sigma~|~veri,I) = \int_{x_0 - \sigma}^{x_0 + \sigma} P(X~|~veri,I) dX \approx 0.67 $$Örnek: Yazı / Tura Probleminde En İyi Değer Hesabı¶

Tekdüze (ing. uniform, flat) öncül (prior) ile binomial olabilirlik fonksiyonlarının (likelihood function) kullanarak hileli madeni parayla yazı / tura atışı örneğinde ardıl olasılık yoğunluk dağılımı fonksiyonunu

$$ P(T~|~veri,I)~\alpha~T^R~(1 - T)^{N-R} $$şeklinde elde etmiştik. Bu ifadenin doğal logaritmasını alarak $L$ fonksiyonunu hesaplayacak olursak

$$ L = sbt~+~R~ln(T) + (N-R)~ln(1 - T) $$ifadesi elde edilir. Bu ifade değişkeni olan $T$'ye göre iki kez türevlenirse,

$$ \frac{dL}{dT} = \frac{R}{T} - \frac{N-R}{1-T} \rightarrow \frac{d^2L}{dT^2} = -\frac{R}{T^2} - \frac{N-R}{(1-T)^2} $$elde edilmiş olur. En olası değeri bulmak için birinci türev $0$'a eşitlenir ve cebirsel düzenleme yapılacak olursa,

$$ T_0 = \frac{R}{N} $$bulunmuş olur. Bu basit bir şekilde en olası hilelilik değerinin tura sayısının toplam yazı/tura atış sayısına oranı olduğunu gösterir. Dağılımın standart sapması ise $L$'nin ikinci türeviyle verilir.

$$ \frac{d^2 L}{dT^2}|_{T_0} = -\frac{N}{T~(T - 1)}$$Standart sapma hatırlanacağı gibi bu değerin tersinin karaköküdür.

$$ \sigma = \sqrt{\frac{T~(T - 1)}{N}} $$$T$ (atışın turaya yanlılık oranı) bir süre deney yaptıktan sonra $T_0$'a doğru yakınsar ve ardılın maksimumu $T_0$ civarına gelir. Ancak bu maksimum etrafındaki dağılımın standart sapmasının azalması (yani bu maksimumun daha güvenilir hale gelmesi) daha çok veri almakla ($N$'i büyütmekle) mümkündür. Ayrıca bu denklemden adil bir atışın ($T \sim 0.5$) yanlılık oranını bulmak çok daha zordur; zira $T_0 = 0.5$ için standart sapma ifadesinin bölüm çizgisinin üstünde kalan tarafı ($T_0 \times (1 - T_0)$) maksimum olur. Dağılımın genişliği de bu değer için doğal olarak maksimumdur!

Astronomide Modelleme ve Bayesian İstatistik¶

Astronomide (aslında tüm bilimlerde) istatistik yaklaşımlara başvurmamız gerektiğinde (örneğin geçerli bir teoremiz olmadığında) en temel problem verinin yetersizliğidir. Örneğin galaksimizdeki ötegezegenlerin oluşumuna ilişkin bir çalışma yapmak istediğimizde tüm ötegezegen sistemlerine ilişkin tüm parametrelere (popülasyon) sahip olmadığımız için bugüne kadar keşfedilenlerin bilinen parametreleri (örneklem) üzerinden çıkarım yapmak zorunda kalırız.

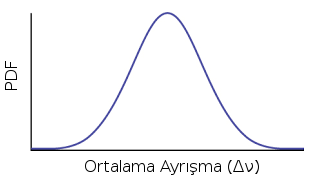

Örneğin Güneş-benzeri salınımlar gözlenen yıldızlarda ortalama büyük ayrışma (ing. large separation) gibi bir parametreyle ilgileniyorsanız, ancak bu parametrenin hesaplandığı (örneğin Kepler örneklemi) örneklemle sınırlı kalırsınız. Örneklemeniz gelişip (örneğin TESS örneklemi) parametrenin yeni bir ortalama değerini elde ettiğinizde bu değer de tüm Güneş-benzeri yıldızlarınkiyle (popülasyon) aynı olmaz. Buna örneklem hatası (ing. sampling error) diyoruz. Frekansçı yaklaşımda popülasyonun ortalama büyük ayrışması sabit bir değerken, değişen şey veri setidir. Bayesian istatistiksel yaklaşımda ise popülasyon gibi bir bilgi olmadığı için, elde ettiğimiz şey elimizdeki veriye dayanarak ortalama büyük ayrışmanın alabileceği tüm değerlerin olasılıkları, yani bir olasılık dağılımıdır. Dolayısı ile değişenimiz aslında ortalama büyük ayrışma olur, sabit olansa elimizdeki veri setidir.

Dolayısıı ile hesaplamaya çalıştığımız şey elimizdeki veriyle herhangi bir ortalama ayrışma değerinin elde edilme olasılığıdır ($P(\Delta \nu~|~veri$).

Bunun için öncelikle $\Delta \nu$'nün herhangi bir değeri için elimizdeki verinin türemiş olma ihtimaline bakarız (olabilirlik fonksiyonu, likelihood function). Daha sonra eğer hiç veri almamış olsaydık ortalama ayrışma için her bir değerin olasılığının ne olması gerektiğini düşünürüz (öncül, prior). Ortalama ayrışma için her bir değerin olasılığının ne olması gerektiği teoriden geliyor olabilir (ing. informative), tahmini bir değer etrafında rastgele dağıldığı öngörülebilir (ing. random) veya her değeri alma ihtimali aynı olabilir (ing. uninformative). Son olarak da her bir ortalama ayrışma için bu ayrışma değerini elde etme olasılığımıza bakarız (kanıt, evidence). Sonuçta elde etmek istediğimiz de herhangi bir ortalama ayrışma değerinin elde edilme olasılığı (ardıl, posterior) ve hangi ortalama ayrışma değerinin en olası olduğudur (ardılın maksimum değeri).

$$ P(\Delta \nu~|~veri) = \frac{P(veri~|~\Delta \nu) \times P(\Delta \nu)}{P(veri)} $$Gerçekte bir modelimiz olmadan ne herhangi bir ortalama ayrışma değeri için elimizdeki veriyi elde etme olasılığını (olabilirlik fonksiyonunu), ne her bir ortalama ayrışma değerinin olasılığını (öncül), ne de tüm ortalama ayrışma değerleri için olasılık hesaplamamız (kanıt) mümkündür. Bu nedenle bu ifadeye bir modelin varlığında bu olasılıkların hesaplanacağını girmeliyiz.

$$ P(\Delta \nu~|~veri,model) = \frac{P(veri~|~\Delta \nu,model) \times P(\Delta \nu~|~model)}{P(veri)} $$Kavramsal Örnek: CoVid 19¶

Soru: Diyelim ki iki farklı ülkeden birinde bireylerin yarısı bir virüsten (SARS-CoV2) etkilenmiş durumda ($\theta = 1$), diğerinde ise aynı virüsten etkilenen yok ($\theta = 0$). Bu iki farklı ülkeden Türkiye'ye gelen 3 bireyin hiçbiri bu virüsten etkilenmemiş olsunlar. Bu 3 bireyin hepsinin virüsten etkilenmeyen ülkeden ($\theta = 1$) gelme olasılığı nedir?

Çözüm: Öncelikle >Olabilirlik Fonksiyonu’nu oluşturalım.

$f(\theta)$, herhangi bir bireyin virüsten etkilenme olasılığı ise model bu olasılıkları belirleyen matematiksel ifade olmalıdır. 1. ülke için herhangi bir bireyin virüsten etkilenme olasılığı $f(\theta = 1) = 1/2$, 2. ülke için ise $f(\theta = 0) = 0$ olsun. Yani 1. ülkenin yarısı "enfekte", 2. ülkede ise hiç kimse enfekte değil!

Elimizdeki veri rastgele seçilmiş 3 bireyin 3’ünün de virüsten etklienmemiş olması: $x_1 = 0$, $x_2 = 0$, $x_3 = 0$. Her bir birey için virüsten etkilenmeme ihtimali ise $1 – f$. Bu durumda her 3 bireyin de virüsten etkilenmemiş olma ihtimali;

$ P(x_1 = 0, x_2 = 0, x_3 = 0) = (1 – f) \times (1 – f) \times (1 – f) = (1 – f)^3 $ olur.

Bireylerin tamamı, virüsten etkilenvmiş ülkeden geliyorlarsa: $P(x_1 = 0, x_2 = 0, x_3 = 0) = (1 - 1/2)^3 = 1 / 8 $

Bireylerin tamamı virüsten etkilenmemiş ülkeden geliyorlarsa: $P(x_1 = 0, x_2 = 0, x_3 = 0) = (1 - 0)^3 = 1 $

Bizim aradığımız olabilirllik fonksiyonu eldeki gözlemsel verinin ($x_1 = 0$, $x_2 = 0$, $x_3 = 0$) tüm bireylerin yarısının virüsten etkilenmiş ülkeden gelmesi ($\theta = 1$) durumunda elde edilme olasılığını vermelidir:

$$ P(veri~|~\theta = 1, model) = 1/8 $$Öncül (prior), hiçbir veri görmeden (hiçbir kanıta dayanmaksızın) her bir durum için nasıl bir olasılık öngördüğümüzü belirler. Örnek problemimiz için popülasyon hakkında bir bilgilmiz olmadığından her iki durumda da seçilen bireyin virüsten etkilenmiş ülkeden gelme olasılığı ($P(\theta = 1) = 1/2$) ve etklenmemiş ülkeden gelme olasılığı ($P(\theta = 0) = 1/2$) eşit ve 1/2‘dir diyebiliriz. Model seçimimiz buna herhangi bir kısıt koymamaktadır. Bu durumda öncül,

$$ P(\theta = 0~|~model) = \frac{1}{2} $$$$ P(\theta = 1~|~model) = \frac{1}{2} $$Kanıt, aslında tıpkı olabilirlik fonksiyonu gibidir, sadece $\theta$’dan bağımsız olup, eldeki veriyi $\theta$’nın tüm değerleri için elde etme olasılıklarının toplamıdır.

$$ P(veri~|~model) = \sum_{\theta}^{} P(\theta~|~model) \times P(veri~|~\theta,model) $$Örneğimizdeki veriyi ($x_1 = x_2 = x_3 = 0$) $\theta$’nın tüm seçenekleri için elde etme olasılığımıza $P(veri~|~model$) bakalım. $\theta = 0$ seçimi için bu olasılık $1$ (eğer bireyler virüsten etkilenmemiş ülkeden geliyorsa hepsinin virüsten etkilenmemiş olma olasılığı $1$) yani $\%100$’dür. $\theta = 1$ seçimi için ise bu olasılık $1/8$’dir ($(1 - 1/2)^3 = 1/8$). Rastgele seçilen bir bireyin virüsten etkilenmemiş ($P(\theta = 0)$) ya da etkilenmiş ($P(\theta = 1$)) kabileden gelme olasılığının her ikisi de $1/2$’dir ($P(veri~|~\theta,model) = 1/2$). Bu olasılıklar toplandığında;

$$ P(veri~|~model) = P(\theta = 0~|~model) \times P(veri~|~\theta = 0,model) + P(\theta = 1~|~model) \times P(veri~|~\theta = 1,model) $$$$ P(veri~|~model) = \frac{1}{2} \times 1 + \frac{1}{2} \times \frac{1}{8} = \frac{1}{2} + \frac{1}{16} = \frac{9}{16} $$Ardıl (Posterior): Örneğimizde rastgele seçilen her 3 bireyin de virüs taşımadığını gösteren veri setimiz ($x_i = 0$; $i=1,2,3$) ve modelimiz ($f(\theta = 0) = 0$, $f(θ = 1) = 1/2$) ışığında her üç bireyin de virüsten etkilenmiş ülkeden gelme olasılığını hesaplayalım.

$$ P(\theta = 1~|~veri,model) = \frac{P(veri~|~\theta = 1, model) \times P(\theta = 1~|~model)}{P(veri~|~model)} $$Tüm bireylerin virüsten etkilenmiş ülkeden geliyor olmaları durumunda elimizdeki veri setini (3’ü de virüsten etkilenmemiş bireyler) türetme ihtimali $P(veri~|~\theta = 1, model) = 1/8$. Rastgele seçilen bir bireyin virüsten etkilenmiş ülkeden geliyor olma ihtimali $P(\theta = 1) = 1/2$. Tüm $\theta$ olasılıkları üzerinden bu verinin türetilme ihtimali $P(veri~|~model) = 9/16$ olduğuna göre;

$$ P(\theta = 1~|~veri,model) = \frac{1/8 \times 1/2}{9/16} = \frac{1}{9} $$Bu işlemi tüm bireylerin virüsten etkilenmemiş ülkeden geliyor olmaları durumu için de yapabiliriz. Elimizdeki veri setini (3’ü de virüsten etkilenmemiş bireyler) bu durumda türetme ihtimali $P(veri~|~\theta = 0, model) = 1$. Rastgele seçilen bir bireyin virüsten etkilenmemiş kabileden olma ihtimali $P(\theta = 0) = 1/2$. Tüm $\theta$ olasılıkları üzerinden bu verinin türetilme ihtimali $P(veri~|~model) = 9/16$ olduğuna göre;

$$ P(\theta = 0~|~veri,model) = \frac{P(veri~|~\theta = 0, model) \times P(\theta = 0~|~model)}{P(veri~|~model)} $$$$ P(\theta = 0~|~veri,model) = \frac{1 \times 1/2}{9/16} = \frac{8}{9} $$Sonuç olarak elimizdeki veri ve modele dayanarak tüm bu bireylerin virüsten etkilenmemiş ülkeden geliyor olma ihtimali $8/9$, diğer ülkeden geliyor olma ihtimalleri ise $1/9$’duır ve bu iki ihtimalin toplamı da doğal olarak $1$ yapar.

Bayes Faktörü İle Model Karşılaştırma¶

Bir model seçimi için (örneğimizde $\theta = 1$) için elde edilen ardılın (posterior), diğer bir model seçimi için (örneğimizde $\theta = 0$) için elde edilen ardıla oranına Bayes faktörü adı verilir. Bu oranda her iki ardılı hesaplarken bölen olarak kullanılan $P(veri~|~model)$ olasılıkları (yani kanıtlar) birbirini götürür. Zira veri sabittir!

$$ \frac{P(\theta = 1~|~veri,model)}{P(\theta = 0~|~veri,model)} = \frac{1/9}{8/9} = \frac{1}{8} $$Bir başka deyişle bu üç bireyin enfekte olmamış ülkeden geliyor olması, enfekte olmuş ülkeden geliyor olmalarından 8 kat daha fazla olasıdır!

Aslında veri sabit olduğu için elimizdeki veriyle farklı modeller üretip karşılaştırırken dayandığımız kanıt (evidence) hep aynı olduğundan bu terimi hesaplamak zorunda değiliz. Bu terimi hesaplamak ayrıca oldukça zordur. >ira tüm modeller için ayrı ayrı bu model doğru kabul edildiğinde elimizdeki verinin türeme ihtimallerinin hesaplanıp toplanmasını (olabilirlik fonksiyonunun tüm olası modeller için elde edilip toplanmasını) gerektirir ki bu maliyetli bir iştir.

Bu nedenle ardıl (posterior) hesaplanırken başvurulan pek çok yöntem ( Monte Carlo Markov Zinciri (MCMC) (Metropolis-Hastings ve diğerleri), Nested Sampling...) bu terimi hesaplamamaya dayanır.

$$ P(\theta~|~veri) \alpha P(veri~|~\theta) \times P(\theta) $$Kaynaklar¶

- Measurements and their Uncertainties, Ifan G. Hughes & Thomas P.A. Hase, Oxford University Press, 2010

- Data Reduction and Error Analysis for the Physical Sciences, Philip R. Bevington & D. Keith Robinson, MC Graw Hill, 2003

- Görseller

- Devinderjit Sivia, John Skilling, “Data Analysis: A Bayesian Tutorial” Oxford University Press, USA (2006)

- Bayesian Statistics: A Comprehensive Course, Ox Education

- "Bayesian Analysis in Python", Osvaldo Martin, Packt Publishing, 2nd ed., 2018